Nvidia将为数据中心带来双GPU_nvidia web helper.exe无法找到入口

目录:

1.nvidia数据中心显卡有哪些

2.英伟达 数据中心

3.英伟达数据中心gpu

4.此nvidia

5.nvidia wed helper service

6.英伟达gpu芯片已在数据中心的ai训练领域获取不少

7.nvidia server

8.英伟达数据中心业务

1.nvidia数据中心显卡有哪些

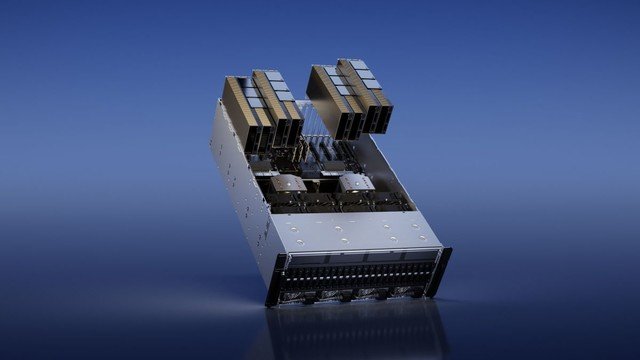

Nvidia在其GTC 2023年春季主题演讲中宣布了一个新的双GPU产品,H100 NVL这不会带来SLI或多GPU游戏的回归,也不会是最好的游戏显卡之一,而是针对不断增长的AI市场从Nvidia发布的信息和图片来看,H100 NVL(H100 NVLink)将在顶部采用三个NVLink连接器,相邻的两块卡可插入独立的PCIe插槽。

2.英伟达 数据中心

这是一个有趣的变化,显然是为了适应不支持Nvidia的SXM选项的服务器,重点是推理性能而不是训练NVLink连接应该有助于提供NVSwitch在SXM解决方案上提供的缺失带宽,而且还有一些其他明显的区别。

3.英伟达数据中心gpu

以规格为例以前的H100解决方案--包括SXM和PCIe--都配备了80GB的HBM3内存,但实际包装包含六个堆栈,每个堆栈有16GB的内存目前还不清楚是否有一个堆栈被完全禁用,或者是用于ECC或其他目的。

4.此nvidia

我们所知道的是,H100 NVL每个GPU将有94GB,总共有188GB HBM3我们认为每个GPU "缺少 "的2GB是为了ECC功率比H100 PCIe略高,每个GPU为350-400瓦(可配置),增加50瓦。

5.nvidia wed helper service

同时,总性能实际上是H100 SXM的两倍:134 teraflops的FP64,1,979 teraflops的TF32,和7,916 teraflops FP8(以及7,916 teraops INT8)。

6.英伟达gpu芯片已在数据中心的ai训练领域获取不少

基本上,这看起来与H100 PCIe的核心设计相同,它也支持NVLink,但现在可能启用了更多的GPU核心,而且内存增加了17.5%内存带宽也比H100 PCIe高一些,每个GPU为3.9TB/s,合计7.8TB/s(而H100 PCIe为2TB/s,H100 SXM为3.35TB/s)。

7.nvidia server

由于这是一个双卡解决方案,每张卡占用2个插槽的空间,Nvidia只支持合作伙伴和认证系统的2至4对H100 NVL卡一对的价格是多少,它们是否可以单独购买?这还有待观察,尽管单块H100 PCIe有时可以找到,价格约为28,000美元(在新标签中打开)。

8.英伟达数据中心业务

因此,80,000美元购买一对H100 NVL似乎并不是不可能的事

以上就是关于《Nvidia将为数据中心带来双GPU_nvidia web helper.exe无法找到入口》的全部内容,本文网址:https://www.7ca.cn/baike/12599.shtml,如对您有帮助可以分享给好友,谢谢。