DNN模型总结-d&m模型

深度神经网络(Deep Neural Networks,简称DNN)是深度学习的基础。本文主要讲解DNN网络模型结构以及对DNN模型的一些理解。

学习DNN首先要了解组成它的基本单元——感知机。之前的文章“感知机”已经讲解了感知机的相关知识,如果不了解感知机可以参考前文。链接:感知机

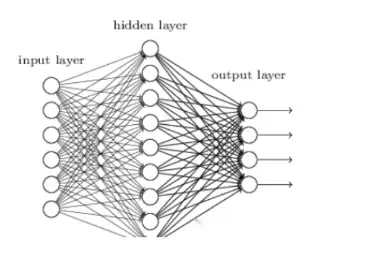

首先给出一个普适的DNN模型结构图,先有一个直观的了解,后面会一步步解释该模型。

1.从感知机说起

可以看到,神经网络就是基于感知机的拓展,是由一群感知机相互作用组合而成。

我们从局部的一个感知机进一步了解一下构成DNN模型中的神经元(即图中的⚪)以及它们之间的连线都代表了什么。

感知机的表示如下

注:这里的b与“感知机”一文中的w0*x0(x0=1)一样。

整体上理解感知机:感知机其实是对n个输入特征的线性组合,然后经过一个激活函数(图中f部分),对线性组合后的值完成非线性的转换,得到-1或+1的类别标签。

特征经过输入到神经元的连线实现加权,神经元将所有输入加权求和,再加上一个偏置项b,对得到的结果经由激活函数f作用后得到非线性处理后的结果y^。进一步观察,输入到神经元的输入可以有多个,w就有多个,这取决于前面有多少个特征输入过来,而b只有一个,可以理解为b是绑定在神经元上的。(另一种理解:因为b本来就是一个常数,跟输入的特征多少无关,即使每个特征都带有自己的常数项b^,加和之后还是一个常数)。

2.回到DNN模型

从一个感知机回到DNN网络结构,DNN其实就是多个感知机的有序组合,DNN也叫做多层感知机(MLP)。深度神经网络中深度一词是说它是由很多层次的网络组成,按不同层次的位置划分,神经网络层可以分为三类,输入层,隐藏层和输出层,一般来说第一层是输入层,最后一层是输出层,而中间的层数都是隐藏层。输入层对应了n个输入特征,它不需要经过激活函数的非线性化处理,每个特征经由不同的连线,即不同的权重w输入到下一层神经网络,而下一层的每一个神经元对所有输入加权求和,加偏置项,经过激活函数得到输出,同时也是再下一层神经网络的输入……如此传递下去,直到输入给输出层,同样的,输出层的每一个神经元对所有输入加权求和、加偏置后,经过激活函数得到输出;输入层的神经元数量由实际问题输入的特征数量决定,而输出层神经元的数量则由实际要解决的问题决定,是分类问题还是回归问题、是二分类问题还是多分类问题?根据问题决定输出是一个值还是多个值,至于中间神经网络的层数以及每一层神经元的个数,需要根据待解决问题的复杂度灵活调整,问题越复杂需要的层数和神经元个数越多。

深度神经网络从理论上来说可以描述任何复杂的问题。因为每一个激活函数实现了对输入的非线性处理,然后又经过多层网络的叠加,只要参数w和b合适,理论上是可以拟合任何函数的。隐层的数量越多,可以表达的复杂程度也就越高。

3.DNN神经网络对感知机的拓展

一个感知机可以认为是一个最简单的神经网络模型,而DNN是由感知机组成,但又对感知机进行了拓展,具体来说有一下几点:

a:加入了隐藏层,增强了模型的表达能力。

b:输出层的输出可以有多个,使模型可以解决的问题更加复杂。

c:拓展了激活函数,DNN的激活函数有多种选择,包括tan、softmax、Relu等等,为神经网络的表达能力进一步增强。

4.DNN神经网络的特点

DNN神经网络也叫全连接神经网络,它的一个特点就是层与层之间是全连接的,层与层所有神经元节点之间都有连接,也就是说,第i层的任意一个神经元一定与第i+1层的任意一个神经元相连。

5.模型的学习过程:前向传播和反向传播。

前向传播和反向传播图

模型要学习的参数就是涉及到的各个w和b

DNN的前向传播

DNN的前向传播过程其实已经描述过了,就是利用若干个权重系数矩阵W,偏倚向量b来和输入值向量X进行一系列线性运算和激活运算,从输入层开始,一层层地向后计算,一直到运算到输出层,得到输出结果为止。

DNN的反向传播

前向传播是从输入侧到输出侧的数据计算流向,而反向传播是从输出侧到输入侧的传递过程,首先需要选定一个损失函数(包含w和b的函数),来度量训练样本计算出的输出和真实的训练样本标签值之间的损失,为使损失函数最小化,对其求极值,得到w和b的更新量,损失一直反向传递,直到完成对所有w和b的参数更新,即完成一轮的学习。利用所有数据进行多轮的学习,最终的目的就是找到一组合适的参数,使模型预测的输出值和实际值的差距最小,即损失函数最小。(更为详细的反向传播过程这里不再展开描述了)

以上就是DNN模型的结构介绍以及学习过程。

以上就是关于《DNN模型总结-d&m模型》的全部内容,本文网址:https://www.7ca.cn/baike/70252.shtml,如对您有帮助可以分享给好友,谢谢。